Pochi Paesi hanno votato contro la Risoluzione Onu che potrebbe portare ad un Trattato internazionale che vieti i sistemi d’arma autonomi, come spiega Francesco Vignarca, coordinatore della Rete Italiana Pace e Disarmo.

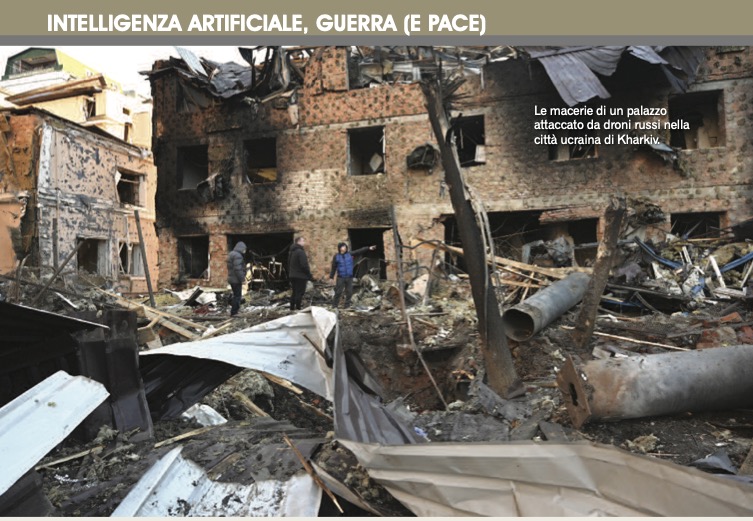

Ormai è ben diffusa la consapevolezza dell’impatto problematico e negativo che potrebbe derivare da un’applicazione militare dell’Intelligenza Artificiale (e in generale dell’automazione). Una decina di anni fa (quando venne scoperta la campagna “Stop Killer Robots”, rilanciata in Italia da Rete Pace Disarmo e Archivio Disarmo) solo alcuni scienziati ed attivisti avevano compreso la pericolosità di affidare alle macchine dei compiti bellici che prescindessero dal controllo umano (fino ad arrivare alla possibilità di prendere decisioni di vita o di morte). Oggi invece, anche a seguito delle notizie provenienti dal conflitto in Ucraina (con l’utilizzo massiccio di droni e sciami di munizioni) e da quello a Gaza (con l’uso da parte di Israele di sistemi di Intelligenza Artificiale per definire obiettivi di bombardamento), la situazione è ben chiara. Senza dimenticare il messaggio di papa Francesco per il primo gennaio scorso, dedicato opportunamente a “Intelligenza Artificiale e pace”.

Per tali motivi le decisioni prese in ambito ONU a fine 2023 sono importanti e positive: il 22 dicembre 2023 ben 152 Paesi hanno infatti votato a favore di una Risoluzione dell’Assemblea Generale sui pericoli dei sistemi di armi autonome letali. In tale contesto solo quattro hanno votato contro (Bielorussia, India, Mali e Russia) mentre 11 si sono astenuti (Cina, Iran, Israele, Madagascar, Corea del Nord, Niger, Arabia Saudita, Sud Sudan, Siria, Turchia ed Emirati Arabi Uniti). La Risoluzione 78/241 riconosce in maniera formale e ufficiale le «gravi sfide e preoccupazioni» sollevate dalle «nuove applicazioni tecnologiche in ambito militare, comprese quelle relative all’intelligenza artificiale e all’autonomia nei sistemi d’arma». Per la società civile internazionale e per gran parte della comunità scientifica mondiale da tale Risoluzione dovrebbe derivare un percorso di negoziato per nuovo Trattato internazionale che vieti (e ne regolamenti la ricerca collegata) i sistemi d’arma autonomi che selezionano bersagli e decidono l’utilizzo della forza basandosi sull’elaborazione dei sensori piuttosto che su input umani. «L’ampio sostegno della risoluzione dimostra che i governi sono pronti ad agire e dovrebbero procedere senza indugio con un nuovo Trattato internazionale» viene sottolineato dagli attivisti, che da tempo evidenziano i pericoli derivanti dall’eliminazione del controllo umano dall’uso della forza.

ARMI AUTONOME SEMPRE PIÙ LETALI

Come già accennato, alcuni sistemi d’arma con un certo grado di autonomia esistono da anni, ma i tipi, la durata di funzionamento, la portata geografica e l’ambiente in cui tali sistemi operano sono finora rimasti limitati a situazioni particolari e circoscritte. Tuttavia, i progressi tecnologici stanno stimolando lo sviluppo di sistemi d’arma autonomi che operano senza un significativo controllo umano, delegando le decisioni di vita e di morte alle macchine: e sarebbe proprio una macchina, anziché l’operatore umano, a determinare le condizioni e la modalità dell’uso della forza. Anche letale.

In tale prospettiva di pericolo si sono svolti per anni, e già a partire dal maggio 2014, colloqui sui sistemi di armi autonome letali presso la Convenzione sulle armi convenzionali (CCW) a Ginevra, senza che però questo processo abbia permesso di raggiungere risultati sostanziale. La ragione principale della mancanza di progressi nell’ambito della CCW è che i Paesi membri si affidano a un approccio decisionale basato sul consenso, il che significa che un singolo Paese può respingere una proposta, anche se tutti gli altri Paesi sono d’accordo. Una manciata di grandi potenze militari ha quindi sfruttato questa situazione per bloccare ripetutamente le proposte di negoziare uno strumento giuridicamente vincolante.

Di fronte a questo muro di gomma la società civile internazionale ha intensificato gli sforzi per costruire un altro percorso, in questo aiutata anche dal Segretario Generale ONU Antonio Guterres e dalla presidente del Comitato internazionale della Croce Rossa Mirjana Spoljaric che nell’ottobre 2023 hanno lanciato un appello congiunto agli Stati membri delle Nazioni Unite con l’obiettivo di negoziare un Trattato internazionale entro il 2026 per vietare e regolamentare i sistemi di armi autonome. Uno sprone che ha spinto l’Austria a presentare, insieme a 42 Stati co-sponsor, una bozza di testo alla Prima Commissione per il Disarmo e la Sicurezza Internazionale dell’Assemblea ONU, dove ha superato una prima votazione il 1° novembre scorso, con 164 voti a favore, cinque contrari e otto astensioni. Per giungere poi alla Risoluzione definitiva di fine dicembre che chiede allo stesso Segretario generale delle Nazioni Unite Guterres di raccogliere le opinioni dei Paesi e delle altre parti interessate sui modi per affrontare le preoccupazioni sollevate dai sistemi di armi autonome «da prospettive umanitarie, legali, di sicurezza, tecnologiche ed etiche» e di riportare tali opinioni in un rapporto da discutersi in un punto specifico sui «sistemi di armi autonome letali» inserito all’ordine del giorno provvisorio dell’Assemblea generale delle Nazioni Unite del 2024.

In quel contesto si potrà più efficacemente affrontare la sfida proposta dallo sviluppo dei robot killer con una maggiore considerazione delle preoccupazioni che sono state trascurate nelle discussioni tenute finora, tra cui le prospettive etiche, il diritto internazionale e le norme sui diritti umani, la proliferazione e l’impatto sulla sicurezza globale e sulla stabilità regionale e internazionale, tra cui il rischio di una corsa agli armamenti e l’abbassamento della soglia di conflitto.